Les interconnexions de Data Centers constituent un segment important et à croissance rapide. Cet article explore plusieurs raisons de cette croissance, y compris les changements du marché, d'architecture et technologiques.

L'énorme croissance des données a entraîné la construction de campus de centres de données, notamment de Data Centers Hyperscales.Dans ce contexte, plusieurs bâtiments d'un campus doivent tous être connectés avec une bande passante adéquate. Quelle bande passante demander? Pour garder les informations circulant entre les Data Centers sur un seul campus, chaque Data Center pourrait transmettre à d'autres Data Centers dans des capacités allant jusqu'à 200 Tbit / s aujourd'hui, avec des bandes passantes plus élevées nécessaires à l'avenir (voir figure 1).

D'où vient le besoin d'une si grande quantité de bande passante entre les bâtiments d'un campus? Cela peut s'expliquer par des tendances croissantes sur deux fronts. Premièrement, la croissance exponentielle du trafic Est-Ouest renforcée par la communication de machine à machine. La deuxième tendance est liée à l'adoption d'architectures de réseaux plus horizontaux, tels que les réseaux Spine-and-Leaf ou CLOS. L'objectif est d'avoir une grande structure réseau sur le campus, nécessitant une grande connectivité entre les installations.

Traditionnellement, un Data Center était construit sur trois niveaux, avec des routeurs principaux, des routeurs d'agrégation et des switchs d'accès. Bien que mature et largement déployée, l'architecture à trois niveaux ne correspond plus à la charge de travail croissante ni aux exigences de latence des campus Data Center Hyperscale. Aussi ceux-ci se tournent vers l'architecture Spine-and-Leaf (voir figure 2). Dans cette architecture, le réseau est divisé en deux parties. La partie Spine est utilisée pour agréger et acheminer les paquets de données vers la destination finale, et la partie Leaf pour connecter les clients finaux et équilibrer les connexions dnas la partie Spine.

Idéalement, chaque switch Leaf se connecte avec chaque switch Spine pour maximiser la connectivité entre les serveurs. Ainsi, le réseau nécessite de switchs Spine/coeur à haute vitesse. Dans de nombreux environnements, les grands switchs Spine sont connectés à un switch Spine de niveau supérieur, souvent appelé campus ou colonne vertébrale ionique, pour relier tous les bâtiments du campus. En raison de cette architecture de réseau plus plate et de l'adoption de switchs à radix élevé, le réseau devient plus grand, plus modulaire et plus évolutif.

|

||

| Figure 2. L'architecture Spine-and-Leaf et le switch à raidx élevé nécessitent des interconnexions nombreuses dans la structure du Data Center. |

Approches de connexions DCI

Quelle est donc la technologie la meilleure et la plus rentable pour fournir cette quantité de bande passante entre les bâtiments d'un campus de Data Center? Plusieurs approches ont été évaluées pour fournir des taux de transmission à ce niveau. Le modèle le plus répandu consiste à transmettre à des taux inférieurs sur de nombreuses fibres. Pour atteindre 200 Tbit / s en utilisant cette méthode, il faut plus de 3000 fibres pour chaque interconnexion de centre de données. Lorsque vous envisagez les fibres nécessaires pour connecter chaque DC à chaque DC sur un seul campus, les densités peuvent facilement dépasser 10 000 fibres.

Quand est-il judicieux d'utiliser le DWDM ou d'autres technologies pour augmenter le débit sur chaque fibre plutôt qu'une augmentation constante du nombre de fibres? Actuellement, les applications d'interconnexion de Data Center jusqu'à 10 km utilisent souvent des transceivers 1310 nm qui ne correspondent pas aux longueurs d'onde de transmission de 1550 nm des systèmes DWDM. Ainsi, les interconnexions massives sont prises en charge en utilisant un câble à haute densité de fibres entre les Data Centers.

Se pose la question de savoir quand remplacer les transceivers 1310 nm par des transceivers DWDM dans les switchs edge en ajoutant une unité mux / demux. La réponse est quand ou si le DWDM devient une approche rentable pour les liens d'interconnexion des Data Centers du campus. Une fois que cela se produit, la même bande passante sera obtenue en utilisant des transceivers DWDM associés à des câbles à nombre de fibres beaucoup plus bas.

Pour estimer cette transition, nous devons examiner le prix du transceiver DWDM et comparer avec les transceivers titulaires. Sur base de la modélisation des prix pour l'ensemble de la liaison, la prévision actuelle est que les connexions basées sur des architectures à 1310 nm riches en fibres continueront d'être moins chères dans un avenir prévisible (voir figure 3). Une alternative PSM4 (8 fibres) s'est avérée rentable pour les applications de moins de 2 km, un autre facteur qui fait augmenter le nombre de fibres.

Meilleures pratiques pour la sélection des câbles

Vu les besoins en réseaux à densité très haute, voyons comment les développer au mieux. Ces réseaux présentent de nouveaux défis à la fois en matière de câblage et de matériel. Par exemple, l'utilisation de câbles à structure libre et l'épissure à fibre monomode n'est ni évolutive ni réaliste. Si vous installez un câble à fibre 1728 en utilisant une conception de tube à structure libre, votre temps d'épissurage sera supérieur à 100 heures en supposant quatre minutes par épissure. Si vous utilisez une configuration de câble ruban, le temps d'épissurage tombe à moins de 20 heures. Bien que 20 heures soit encore un temps considérable pour épissurer une connexion, cela représente un énorme gain de temps par rapport aux types de câbles à fibre unique.

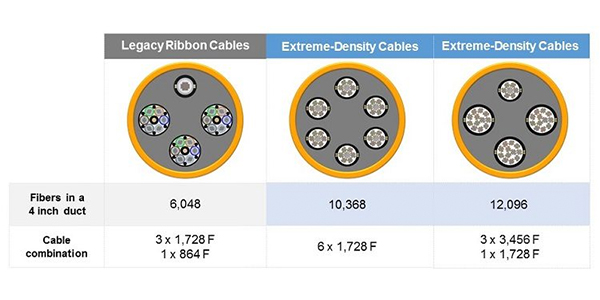

Par ailleurs, les conceptions de câbles traditionnels présentent des défis importants lorsqu'ils sont installés dans des conduites de 2 ou 4 pouces. De nouvelles conceptions de câbles et de rubans ont fait leur apparition sur le marché, ce qui a doublé la capacité des fibres dans la même section. Ces produits se répartissent généralement en deux approches : une approche utilise un ruban matriciel standard avec des sous-unités plus compactes, et l'autre utilise des câbles standard avec un noyau central et des rubans reliés qui peuvent se replier les uns sur les autres (voir Figure 4).

|

||

| Figure 4. Différentes conceptions de câbles rubans pour les applications à densité extrême. |

Utiliser ces nouvelles conceptions de câbles permet une concentration de fibres beaucoup plus élevée dans le même espace de conduite. La figure 5 illustre comment l'utilisation de différentes combinaisons de nouveaux câbles de style extrême densité permet aux propriétaires de réseaux d'atteindre les densités de fibre requises par les interconnexions de Data Center Hyperscale.

|

||

| Figure 5. Utilisation de câbles à densité extrême pour doubler la capacité des fibres dans le même espace. |

Lorsqu'ils utilisent ces nouvelles conceptions de câbles rubans, les opérateurs de réseaux doivent prendre en compte les possibilités d'évolution adéquate utilisant des nombres de fibres très élevés. Il peut être facile de submerger le matériel existant. Plusieurs domaines majeurs sont à considérer lorsque vous développez votre réseau complet.

Combien de câbles internes à l'installation devrez-vous installer pour vous connecter à un câble externe de 1728 à 3456 fibres? Si vous utilisez actuellement des câbles ruban à 288 fibres dans votre environnement interne de l'usine, votre matériel doit être capable de recevoir de manière adéquate 12 à 14 câbles. Votre matériel devrait également gérer 288 épissures de ruban distinctes. L'utilisation de câbles de type à fibre unique et d'une méthode d'épissage à fibre unique dans cette application n'est pas vraiment faisable ou recommandée en raison des temps de préparation massifs et de la gestion des fibres lourde.

Un autre domaine qui peut être difficile est de garder une trace des fibres pour assurer l'épissurage correct. Les fibres doivent être correctement étiquetées et triées immédiatement après l'ouverture du câble en raison de l'ampleur des fibres qui doivent être suivies et acheminées. Veiller à ce que les piles de rubans puissent être regroupées et protégées pendant le chargement dans le matériel devrait être une priorité pour éviter d'endommager les fibres. Dans la plupart des installations, une erreur qui provoque la refonte de la préparation du câble est gérable. Dans le cas des réseaux à densité extrême, une erreur peut avoir un impact sérieux sur l'achèvement du projet et peut engendrer un délai d'une semaine pour un seul emplacement.

Tendances futures en matière de câblage

Quel avenir pour les réseaux à densité extrême? Le facteur le plus important en ce moment est de savoir si le nombre de fibres s'arrêtera à 3456, ou si nous verrons ces nombres aller encore plus haut. Les tendances actuelles du marché suggèrent qu'il y aura des exigences pour des dénombrements même au-delà de 5000. Pour maintenir une infrastructure qui peut encore évoluer, il y aura une pression accrue pour réduire la taille des câbles. Avec la densité de garnissage des fibres qui approche déjà ses limites physiques, les options pour réduire davantage les diamètres des câbles de manière significative deviennent plus difficiles.

Une approche qui gagne du terrain consiste à utiliser des fibres dont la taille du revêtement a été réduite d'une mesure typique de 250 microns à 200 microns. Les tailles de noyau de fibre et de gaine restent les mêmes, il n'y a donc aucun changement dans les performances optiques. Mais cette réduction de taille, lorsqu'elle est étendue sur des centaines à des milliers de fibres dans un câble, peut fournir une réduction substantielle de la section totale du câble. Cette technologie a déjà été appliquée à certaines conceptions de câbles et a été utilisée pour créer des micro-câbles en vrac qui sont disponibles dans le commerce.

Le développement s'est également concentré sur la meilleure façon de fournir des liaisons d'interconnexion de Data Center à des emplacements beaucoup plus espacés et non colocalisés sur le même campus physique. Dans un environnement de campus de Data Center traditionnel, les longueurs d'interconnexion de Data Center typiques sont de 2 km et moins. Ces distances relativement courtes permettent d'utiliser un seul câble pour assurer la connectivité sans aucun point de raccordement. Cependant, les Data Centers étant également déployés autour des zones métropolitaines pour réduire les temps de latence, les distances augmentent et peuvent approcher jusqu'à 75 km. L'utilisation d'une conception de câble à densité extrême dans ces applications est moins rentable en raison du coût de connexion du nombre élevé de fibres sur une longue distance. Dans ces cas, les systèmes DWDM plus traditionnels continueront d'être le choix préféré, avec moins de fibres à 40G et plus.

Nous pouvons nous attendre à ce que la demande de câbles à densité extrême migre des environnements de Data Center vers les marchés d'accès alors que les propriétaires de réseau se préparent pour les prochains déploiements 5G à forte intensité de fibres. Il continuera d'être un défi dans l'industrie de développer des produits qui puissent évoluer pour atteindre le nombre de fibres requis tout en ne surchargeant pas les conduites existantes et les environnements intérieurs.

David Hessong et Derek Whitehurst

Corning Optical Communications

Dernière mise à jour : Mars 2025

Contactez-nous. Nos experts sont là pour vous aider à chaque étape de votre projet.

Que vous ayez besoin d'aide pour votre travail en cours ou pour un projet futur, nous pouvons vous aider. Veuillez remplir ce formulaire pour nous donner quelques informations.

Merci !

Merci de nous avoir contactés. Un représentant de Corning vous contactera prochainement au sujet de votre demande. Si vous avez besoin d'une assistance immédiate, veuillez contacter notre service clientèle au +49 30 5303 2100 ou 00 800 2676 4641.