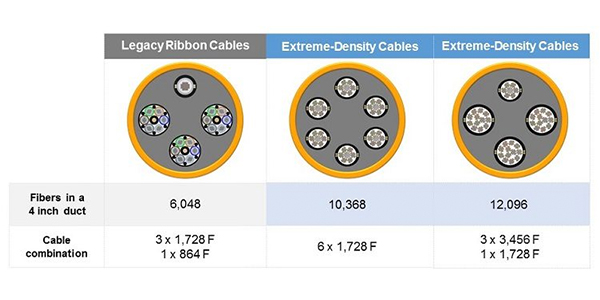

Wie sieht die Zukunft für Netzwerke mit extremer Dichte aus? Der derzeit wichtigste Faktor ist, ob die Anzahl der Glasfasern bei 3456 endet oder ob diese Anzahl noch weiter steigen wird. Aktuelle Markttrends deuten darauf hin, dass es Anforderungen für Faserzahlen auch über 5000 hinaus geben wird. Um eine Infrastruktur aufrechtzuerhalten, die noch skalierbar ist, wird die Notwendigkeit zur weiteren Verkschlankung der Kabeldurmesser zunehmen. Da die Packungsdichte der Fasern bereits an ihre physikalischen Grenzen stößt, werden die Möglichkeiten, die Kabeldurchmesser auf sinnvolle Weise weiter zu reduzieren, immer schwieriger.

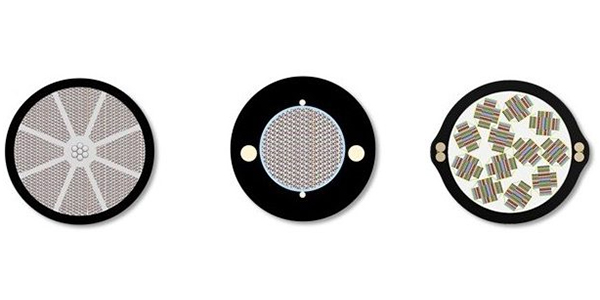

Ein Ansatz, der an Bedeutung gewinnt, ist die Verwendung von Fasern, bei denen die Dicke des Mantelglas von einer typischen Abmessung von 250 Mikrometern auf 200 Mikrometer reduziert wurde. Die Größen von Faserkern und -mantel bleiben gleich, so dass sich die optische Leistung nicht verändert. Aber diese Reduzierung der Beschichtung, wenn sie bei Hunderten bis Tausenden von Fasern in einem Kabel angewendet wird, kann zu einer erheblichen Verringerung des Kabeldurchmessers führen. Diese Technologie wurde bereits in einigen Kabeldesigns angewandt und wurde zur Herstellung von kommerziell erhältlichen Mikro-Bündeladerkabeln verwendet.

Die Entwicklung hat sich auch darauf konzentriert, wie man am besten Rechenzentrumsverbindungen zu Standorten bereitstellen kann, die viel weiter voneinander entfernt und nicht auf demselben physischen Campus angesiedelt sind. In einer typischen Rechenzentrums-Campusumgebung beträgt die typische Distanz zwischen Rechenzentren, die es zu verbinden gilt 2 km und weniger. Diese relativ kurzen Entfernungen ermöglichen die Verwendung eines einzigen Kabels zur Bereitstellung der Verbindung ohne Spleißpunkte. Da Rechenzentren jedoch auch in Ballungsgebieten eingesetzt werden, um die Latenzzeiten zu reduzieren, nehmen die Entfernungen zu und können bis zu 75 km betragen. Die Verwendung eines Kabeldesigns mit extrem hoher Faseranzahl für diese Anwendungen ist aus finanizeller Sicht weniger sinnvoll, da sie mit entsprechenden Kosten für die Verbindung der hohen Faseranzahl über eine lange Distanz verbunden sind. In diesen Fällen werden traditionellere DWDM-Systeme weiterhin die bevorzugte Wahl sein, die eine Übertragung über weniger Fasern bei 40 G und mehr leisten.

Es ist zu erwarten, dass sich die Nachfrage nach Verkabelungen mit extremer Dichte von den Rechenzentrumsumgebungen in die Zugangsnetze verlagern wird, da die Netzbetreiber sich auf die kommenden glasfaserintensiven 5G-Rollouts vorbereiten. Es wird auch weiterhin eine Herausforderung für die Branche sein, Produkte zu entwickeln, die effektiv skaliert werden können, um die erforderliche Faseranzahlen zu erreichen, ohne bestehende Kanal- oder Rohranlagen sowie Innenanlagenumgebungen zu überfordern.