Par Ron Gruen et Russell Kirkland, Corning Incorporated

La technologie dans les Data Centers évolue. Avant de décrire cette évolution, voyons pourquoi elle a lieu. En 2017, près de 250 millions d'utilisateurs se sont connectés à l'Internet pour la première fois. Le nombre d'utilisateurs augmente de 7% chaque année depuis 2018. 11 nouveaux utilisateurs se connectent chaque seconde aux réseaux sociaux. Chaque personne passe en moyenne six heures par jour en ligne. Il est estimé qu'en 2020, à travers le monde la moyenne est de 6 à 7 équipements par personne et de 13 aux USA. Pourquoi tout ceci est-il important ?

La réponse est simple : c'est une question de revenus. Presque toutes les sociétés ont des sites webs pour attirer et interagir avec leurs clients. L'e-commerce a atteint près d' 1,5 trillion $ en 2017. Si votre site web prend plus de trois secondes à télécharger, vous pouvez perdre près d'un quart de visiteurs. Une seconde de retard conduit à une perte de 11% en nombre de pages vues et de 7% en conversions. Une étude d'Ericsson a montré que le buffering de films peut créer le même niveau d'anxiété que regarder seul un film d'horreur ou essayer de résoudre certains problèmes de mathématiques. Tout ceci conduit à des besoins de connexions plus rapides et de plus hautes capacités.

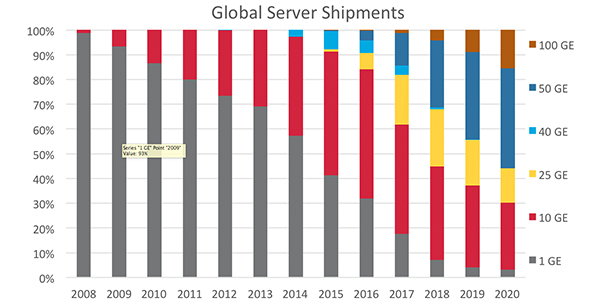

L'activité des serveurs a augmenté ces dernières années. Cette augmentation continue. La vitesse des serveurs tire vers le haut les ventes et le développement des transceivers. Les connexions 1G appartiennent aux reliques du passé (Fig. 1) et seront bientôt rejointes par les 10G. Les transceivers 25G sont sur le marché et seront éclipsés par les 50G dans quelques années. De plus les Data Centers hyperscale et cloud seront les premiers à adopter des vitesses de serveurs 100G. Ces vitesses plus élevées peuvent être atteintes avec des transceivers 2-fibres de débits équivalents ou par des transceivers optique parallèle utilisant 40G, 200G, 100G et 400G au niveau du switch avec des optiques parallèles et des capacités breakout.

|

||

Figure 1. Nombre global de serveurs (source : Groupe Dell’Oro) |

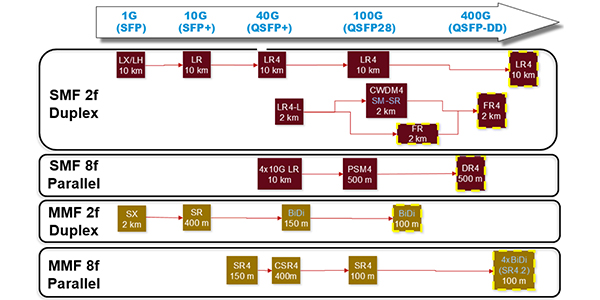

Les fabricants de transceivers utilisent plusieurs technologies pour obtenir les débits de données croissants. Que la connexion entre les transceivers soit avec de la fibre multimode ou monomode, ces technologies utilisent les mêmes outils fondamentaux. Le premier et le plus simple est le débit en baud. En d'autres termes, c'est la vitesse à laquelle vous pouvez allumer ou éteindre le laser qui compte. Cette première méthode a bien fonctionné pour les vitesses basses comme 10G mais est plus difficile à utiliser quand le ratio signal-bruit devient problématique.

L'option suivante est d'augmenter la quantité de fibres. Alors qu'on utilisait deux fibres pour une connexion 10G ou 25G, aujourd'hui huit fibres sont utilisées pour une connexion 40G ou 100G avec plusieurs paires dans une configuration de transmission parallèle. Ensuite, le nombre de longueurs d'ondes peut être augmenté, en utilisant plusieurs sources et le multiplexage du signal dans une fibre monomode, signal ensuite démultiplexé à la réception. C'est ce qu'on appelle WDM ou "wave division multiplexing".

Un autre moyen pour atteindre des vitesses élevées est de changer le format de modulation. Au lieu d'utiliser un "non-retour simple vers zéro" ou NRZ, le transceiver peut utiliser une modulation d'amplitude pulsée (PAM4) pour transporter quatre fois plus de données sur la même durée. Des vitesses de données plus rapides, avec NRZ ou PAM4 requièrent un algorithme de FEC de correction d'erreur. Le bruit ayant un plus grand impact sur PAM4, il a besoin d'un algorithme FEC plus important. Quelle que soit la méthode choisie, vous avez le choix entre une solution 2-fibres ou 8-fibres. Certaines solutions 400G ont utilisé 16 ou 32 fibres, cependant l'un ou l'autre peut être obtenu avec une infrastructure de 8-fibres ou de base-8.

|

||

Figure 2. Voies de migration |

Il peut sembler simple de choisir entre une solution duplex (2 fibres) ou une parallèle (8 fibres) quand on voit comment les transceivers ont traditionnellement été connectés. Prenons cependant le temps d'envisager les deux options et de les évaluer en fonction du prix, de la consommation d'énergie, la densité et la flexibilité.

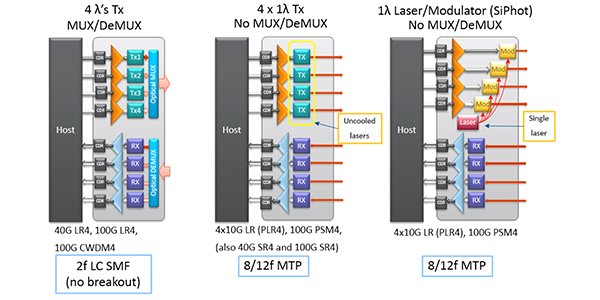

Pour les Data Centers d'entreprise, la longueur moyenne de liaison est de 49 mètres. Plus de 90% des connexions font moins de 100 mètres. Pour la majorité des Data Centers, les fibres multimodes et les optiques qui y correspondent s'avèrent donc suffisantes. Pour les liaisons de plus de 100 mètres, des liaisons optiques monomodes parallèles offrent une option valable. De plus, les prix des optiques pour PSM4 et SR4 sont comparables. Aussi la plupart des Data Centers hyperscale et cloud utilisent presqu'exclusivement des liaisons monomodes. Pour les connexions duplex, de nouveaux composants sont requis pour atteindre les vitesses plus élevées. Par contraste, les connexions en optique parallèle utilisent les technologies existantes pour construire les transceivers de nouvelle génération. Par ailleurs, des optiques parallèles peuvent utiliser soit quatre lasers non refroidis soit un seul laser couplé avec un splitter guide d'ondes et quatre modulateurs. Grâce à ces attributs, ces optiques parallèles coûtent mois à la production et de plus consomment moins d'énergie.

|

||

| Figure 3. Énergie et diminution des coûts avec des transceivers parallèles |

La plupart des propriétaires et opérateurs de Data Center conviennent que l'énergie y constitue le premier poste de dépense. Aussi, toute diminution de consommation d'énergie a un impact positif sur les coûts opérationnels. Une simple connexion 10G connexion utilise 1W d'énergie. Par contre, des optiques parallèles 40G en consomment 1.5W. Puisqu'une solution optique parallèle vous donne quatre liaisons 10G par transceiver, vous pouvez obtenir le même nombre de connexions 10G avec un gain de 60% en énergie. Une autre considération est le prix du refroidissement. En général tout kW d'énergie consommé requiert 1 kW de refroidissement. Logiquement une réduction en consommation d'énergie se traduit aussi par une diminution de l'énergie nécessaire au refroidissement.

Les liaisons optiques parallèles permettent de diminuer le coût total de possession (TCO) grâce à la densité plus importante de la solution. La plupart des cartes switch haute densité SFP+ viennent en général avec un maximum de 48 ports. Vous pouvez acheter une carte QSFP plus haute densité avec 36 ports. Si la carte est utilisée en mode breakout, chaque port peut servir comme ports 10G. Aussi une seule carte QSFP, vous pouvez supporter 144 liaisons 10G. Ceci triple la densité du switch, diminuant le nombre total de cartes requises pour le réseau. Ceci diminue le besoin en équipements liés à l'énergie, ventilateurs, contrôleurs du système, modules et licences de logiciels. Au final, déployer un système avec des optiques parallèles coûte 85% moins cher qu'un système de ports dédiés 10G. Cette réduction en nombre de châssis et cartes apporte de plus une diminution d'environ 67 % les coûts d'énergie et de refroidissement.

Afin de tirer parti de ces attributs permettant de diminuer les coûts, votre système de câblage structuré doit pouvoir supporter une connexion 8-fibres. Une structure de câblage en base-vous offre le plus de flexibilité quant au design du système et vous permet une voie de migration claire vers des vitesses de données plus rapides. Avec des optiques parallèles pour un maximum de densité et des économies en énergie, vous avez une voie claire pour améliorer votre système. Quand le réseau passe des breakouts 10G/25G aux 40G/100G natifs, les optiques et les cartes 40G/100G en mode breakout pourront continuer à supporter les liaisons 40G/100G natives. Vous possédez ainsi la capacité de deux générations de vitesses des switches, cartes et transceivers d'optiques parallèles.

La croissance continue des Data Centers crée de nombreuses questions pour leurs managers et affecte aussi l'infrastructure de câblage pour ces technologies actuelles et futures. L'infrastructure de câblage doit répondre au cahier des charges en terme de délais, être facile à installer sans complexité et pouvoir être mise à jour pour répondre aux besoins d'un environnement riche en technologies. En d'autres mots, l'infrastructure de câblage se doit d'être fiable (uptime 24 x 7 x 365), flexible (modulaire pour permettre les changements), et évolutive (soutenir la croissance des Data Centers).

L'utilisation d'un câblage structuré ne date pas d'hier. Les environnements Data Center continuent de diminuer la pratique de connecter des équipements au fur et à mesure des installations. Les systèmes de câblage optique des Data Centers utilisent des connecteurs multifibres aussi appelés trunks préconnectorisés. En général ils vont de 12 à 144 fibres et connectent différentes zones du Data Center. Cependant la croissance de la taille des Data Centers et les nouvelles architectures réseau ont rendu les tailles de ces trunk insuffisantes. Ces trunks doivent comprendre 288, 432, voire 576 fibres et convenir à une installation intérieure. L'utilisation de trunks à grand nombre de fibres augmente la densité de fibres dans les chemins de câbles. Des trunks plus grands peuvent aussi réduire le temps nécessaire en diminuant le nombre de câbles à tirer, ce qui peut aussi réduire les coûts d'installation.

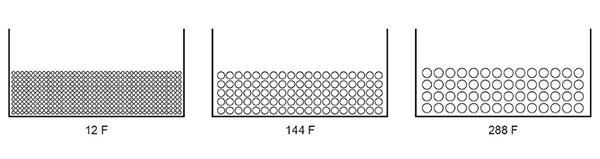

La figure 4 montre la densité de fibres selon trois scénarios.

Total de 4,440 fibres avec 370 trunks EDGE MTP-to-MTP 12-fibres

Total de 13,680 fibres avec 95 trunks EDGE MTP-to-MTP144-fibres

Total de 16,128 fibres avec 56 trunks EDGE MTP-to-MTP 288-fibres

|

||

| Figure 4: Comparaison des ratios de remplissage selon différents trunk (12” x 6”) |

Les Data Centers dépassent les limites du simple building et peuvent comprendre plusieurs bâtiments organisés en campus dont les infrastructures de câblage doivent comprendre des trunks multifibres avec pigtails préconnectorisés ou des installations de câbles bulk. Les trunks pigtail avec un câble intérieur/extérieur peuvent comprendre jusqu'à 864 fibres. Les besoins en connectivité poussent le nombre de fibres sur un câble bulk au-delà de 864 fibres, jusqu'à 1,728 et 3,456 fibres.

Solutions de câblage structuré

Plusieurs solutions existent pour apporter un plus grand nombre de fibres. Selon l'environnement, trois options peuvent être envisagées. La constante dans ces scenarios, ce sont les connecteurs multifibres. Ces connecteurs conduisent à des installations plus rapides et offrent des voies de migration de transceivers 2-fibres vers des transceivers 8-fibres. Utiliser le câblage structuré et des connecteurs multifibres permettra le déploiement dres applications breakout qui réduiront les coûts totaux de possession (TCO).

Trunks de connexion multi-fibres

Des trunks multifibres sont utilisés pour connecter des zones d'un Data Center entre elles. Par exemple, pour connecter la zone de distribution principale (MDA) à la zone de distribution horizontale (HDA) ou celle de distribution de l'équipement (EDA). Les trunks dans une protection de distribution avec des connecteurs multifibres du trunk connectant dans un module or adaptateur. Ceci permet des connections par jarretière au composant actif. Des trunks MTP déployés dans une zone du DC peuvent être déployés dans d'autres zones adjacentes si les chemins de câblage permettent le passage d'une poignée de tirage qui protège le connecteur multifibres. Le déploiement de ces trunks demandent une bonne planification pour que les longueurs de trunks soient correctes et les chemins de câbles atteignables.

2. Trunks Multifibres avec connecteur pigtail

Les trunks pigtails sont utilisés dans quelques applications.

- Dans des chemins de câble (conduite) saturés, lorsque des poignées de tirage ne peuvent être utilisées

- Pour connecter des salles de Data Center entre plusieurs étages ou divers bâtiments d'un Data Center de type campus.

De plus, un trunk pigtail peut aider si les distances entre deux salles à connecter ne sont pas connues.

Après le tirage des trunks pigtail, ils doivent être préparés pour être terminés. Ceci demande l'accès au câble pour exposer la fibre et ensuite effectuer la furcation du câble pour protéger les fibres. La partie nue de l'extrémité du câble sera terminée avec des connecteurs multifibres splice-on, des assemblages pigtail, des cassettes pigtail ou une protection préconnectorisée.

3. Câbles à grand nombre de fibres

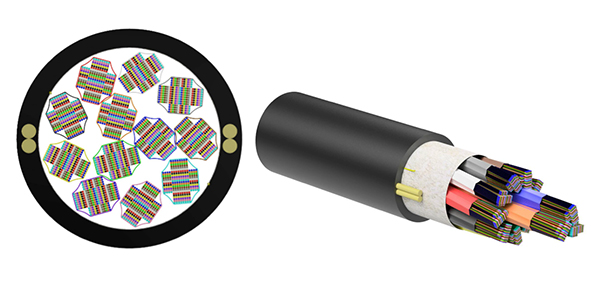

Les câbles à grand nombre de fibres utilisent des fibres à rubans pour maximiser la densité de fibres dans un câble. Les câbles rubans ont un diamètre extérieur plus petit pour une plus haute densité de fibres, ce qui permet de déployer les câbles dans des conduites saturées. Ces câbles comprennent 864, 1728,et 3456 fibres.

Terminer ces câbles peut se faire avec des connecteurs multifibres, des assemblages pigtails, des cassettes pigtails ou des protections préconnectorisées. Ces types de déploiements peuvent prendre plus de temps que les câbles pré-terminés. En effet les deux extrémités du câble doivent être préparées avec des kits de furcation pour protéger la fibre ruban dans l'équipement de distribution. Les performances optiques de câbles terminés sur site peuvent ne pas être aussi bonnes que celles de câbles pré-terminés.

|

||

| Figure 6: Câble densité extrême 3,456-Fibres |

Résumé

Nous avons envisagé plusieurs questions que les managers des Data Centers doivent considérer lorsqu'ils planifient leur Data Center. Alors que la taille des data Centers continue de croître, ces sujets rendront la planification encore plus complexe. Connaître les évolutions technologiques et les attentes futures envers les Data Centers pourra valoriser le processus de design de Data Center et améliorer le coût total de possession.